「ChatGPTを使えば仕事が速くなる」──そんな軽い気持ちで、社員が会社の許可なくAIを使い始めている。そんな状況に、不安を感じているシステム担当者や経営層の方は多いはずです。

現場の「効率化したい」という善意から生まれるシャドーAIですが、実はその裏には、企業の存続を揺るがしかねない重大な情報漏洩のリスクが潜んでいます。一度流出した機密データは二度と取り戻せません。しかし、ただ「利用禁止」と叫ぶだけでは現場の不満が溜まり、さらに隠れて使われるという悪循環に陥ってしまいます。

実際、多くの企業が頭を悩ませているのは、「利便性を損なわずに、いかにガバナンスを効かせるか」という極めて難しいバランス調整です。対策を後回しにしていると、ある日突然、取り返しのつかないトラブルとなって表面化します。

しかし、正しく向き合えばシャドーAIは恐れるものではありません。適切なルール作りと仕組み化を行うことで、「リスク」を「武器」へと変えることができるからです。

この記事では、シャドーAIがもたらす具体的なリスクから、明日から実践できるセキュリティ対策、そして現場と共存するための安全な活用法までを詳しく解説します。

簡単に説明する動画を作成しました!

目次

シャドーAIの概要

シャドーAIとは何か

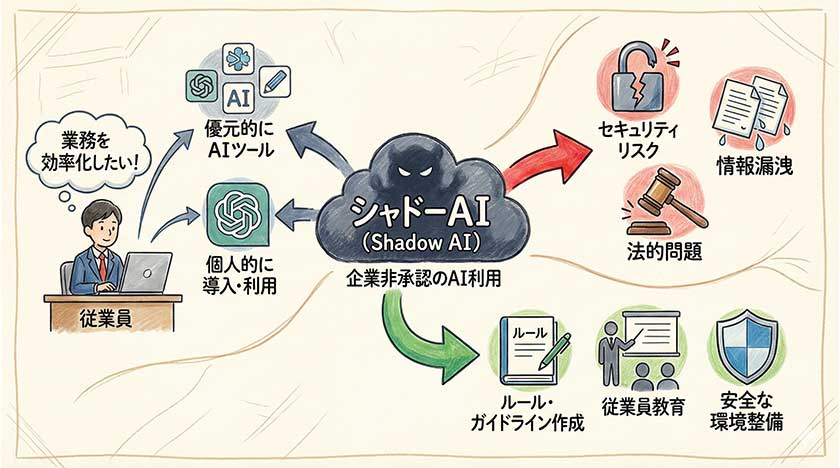

シャドーAIとは、企業が公式に承認していないAIツールやAIの利用を指します。

従業員が業務効率化や生産性向上を目的に、個人的に導入したり、無料の生成AIツールを許可なく使用したりするケースが典型的な事例です。

シャドーAIは、シャドーITの一形態であり、組織が把握していないAIの利用が、セキュリティリスクや情報漏洩の危険を引き起こす可能性があります。

特に、ChatGPTのような生成AIが普及するにつれて、従業員がつい業務でAIツールを使ってしまう状況が増えており、企業は早急に対策を講じる必要があります。

シャドーAIは、企業が管理していないため、不正アクセスやデータ漏洩のリスクが高まり、法的な問題にも発展する可能性があります。

以前、私がコンサルティングを行った企業でも、悪気なく翻訳サイト感覚で機密文書を生成AIに入力してしまっていた事例がありました。現場の「便利だから使いたい」という純粋な動機と、企業側の管理体制のギャップこそが、この問題の本質だと私は感じています。

生成AIの進化と影響

生成AIの進化は目覚ましく、その影響は企業活動のあらゆる面に及んでいます。

特にChatGPTのようなAIツールは、業務における様々なタスクを効率化する高い可能性を秘めており、従業員が個人的に利用する動機となっています。

しかし、生成AIへの機密情報や個人情報の入力は、データ漏洩のリスクを高め、深刻な問題を引き起こす可能性があります。

企業は、生成AIの進化を認識しつつ、その利用に関する明確なルールとガイドラインを作成する必要があります。

これにより、従業員が安全にAIを活用できるようになるだけでなく、企業全体のセキュリティレベルを向上させることが重要です。

生成AIの利用は、メリットとデメリットを十分に理解した上で、慎重に検討すべきです。

ルール作りにおいては、「全面禁止」にするとかえって地下に潜る(さらに見えないところで使われる)リスクを私は懸念します。安全な利用方法を提示し、従業員のITリテラシーを底上げすることこそが、遠回りのようで最も確実な対策となるでしょう。

企業におけるシャドーAIの利用状況

多くの企業において、従業員がシャドーAIを利用している状況が確認されています。

例えば、マーケティング部門の従業員が、業務効率化を目的に個人的にAIツールを導入したり、営業部門の担当者が顧客とのやり取りにChatGPTを使用したりするケースが見られます。

これらの利用は、多くの場合、企業の情報システム部門やセキュリティ担当者の認識外で行われており、セキュリティ上の脅威となる可能性があります。

シャドーAIの利用状況を把握するためには、定期的な監査や従業員へのアンケート調査が有効です。

企業は、シャドーAIの利用がもたらすリスクを理解し、適切な対策を講じることで、安全なAI利用環境を構築することができます。

組織全体でシャドーAIに関する課題を共有し、解決策を検討することが重要です。

実際にアンケート調査を行ってみると、「許可が必要だとは知らなかった」という回答が驚くほど多く返ってくることがあります。まずは現状を正確に把握し、頭ごなしに否定せず対話の場を設けることが、解決への第一歩だと私は考えています。

シャドーAIのリスク

情報漏洩の危険性

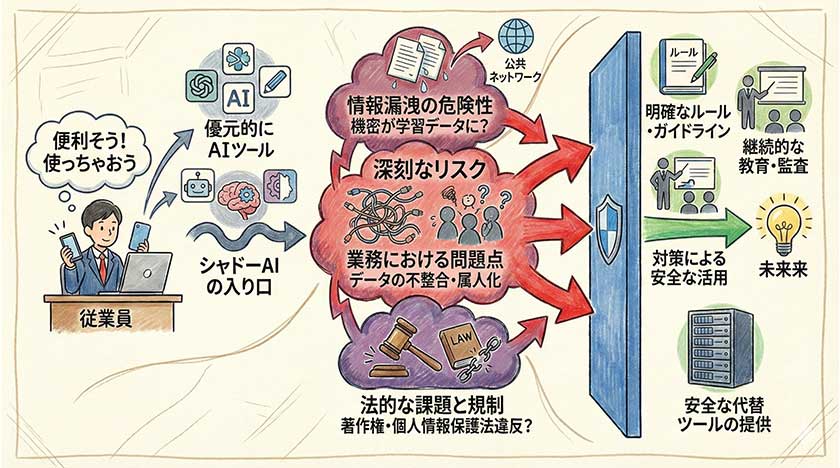

シャドーAIの最大のリスクは、情報漏洩の危険性です。

企業が承認していないAIツールを従業員が個人的に使用する場合、機密情報や個人情報が外部に漏洩する可能性があります。

例えば、従業員がついChatGPTのような生成AIに顧客の個人情報や業務に関するデータを入力してしまうと、それらの情報がAIの学習データとして利用され、意図しない形で公開されてしまう危険があります。

このような事態を避けるためには、企業は従業員に対してシャドーAIのリスクを十分に解説し、情報セキュリティに関する教育を徹底する必要があります。

また、AIの利用に関する明確なルールとガイドラインを作成し、従業員が安全にAIを活用できる環境を整備することが重要です。

これは非常に繊細な問題です。「学習データに使われない設定(オプトアウトなど)」を知らずに、初期設定のまま使い続けている現場を私は数多く見てきました。ツールの禁止よりも、こうした設定の周知徹底の方が、実効性のあるセキュリティ対策になることが多々あります。

業務における問題点

シャドーAIは、業務の効率化を阻害する問題も引き起こす可能性があります。

従業員が個人的に導入したAIツールは、企業の情報システムとの連携が考慮されていない場合が多く、データの整合性やセキュリティ上の問題が発生する可能性があります。

また、シャドーAIの利用が拡大すると、組織全体でのデータ管理が煩雑になり、業務の標準化や効率化が困難になることも考えられます。

さらに、従業員が退職した場合、その従業員が使用していたシャドーAIの管理が途絶え、データのアクセス権が不明になるなどの問題も発生する可能性があります。

これらの問題を解決するためには、企業はAIの利用に関する一元的な管理体制を構築し、従業員が安全かつ効率的にAIを活用できる環境を提供することが重要です。

個人アカウントで作られた業務プロセスは、その人がいなくなった瞬間に「ブラックボックス」化します。私が支援したケースでも、退職者が残したAIのプロンプトが誰にも解読できず、業務が一時停止してしまった事例がありました。属人化を防ぐ意味でも、組織的な管理は不可欠です。

法的な課題と規制

シャドーAIの利用は、企業にとって法的な課題ももたらします。

例えば、従業員がシャドーAIを利用して個人情報を不適切に処理した場合、個人情報保護法に違反する可能性があります。

また、AIが生成したコンテンツが著作権を侵害する場合や、不正確な情報が拡散された場合には、企業が法的責任を問われる可能性もあります。

現在、AIの利用に関する法規制はまだ整備途上であり、企業は最新の法規制の動向を注視し、適切な対策を講じる必要があります。

具体的には、AIの利用に関する社内ルールを明確にし、従業員に対して法的なリスクやコンプライアンスに関する教育を実施することが重要です。

さらに、AIの利用状況を定期的に監査し、法令遵守を徹底する体制を構築することが求められます。

これらの対策を講じることで、企業はシャドーAIによる法的なリスクを軽減し、安全なAI活用を推進することができます。

法規制は日々変化しており、昨日まで問題なかった使い方が明日にはリスクになる可能性もあります。だからこそ、現場任せにせず、法務部門や専門家と連携しながら、柔軟かつ迅速にルールをアップデートしていく姿勢を私は強く推奨しています。

情報漏洩対策

シャドーITの管理方法

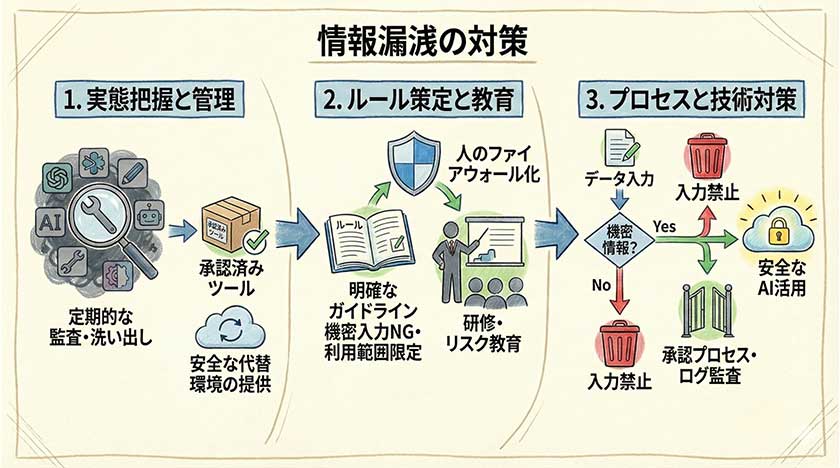

シャドーITの管理は、企業がシャドーAIへの対策を講じる上で非常に重要です。

まず、企業はシャドーITの実態を把握するために、社内のITインフラを定期的に監査し、従業員が許可なく利用しているAIツールやサービスを洗い出す必要があります。

次に、従業員に対して、シャドーITのリスクや情報漏洩の危険性について十分に解説し、企業が承認したAIのみを業務で利用するように徹底させることが重要です。

また、企業は安全なAIツールやサービスを導入し、従業員がそれらを活用しやすい環境を提供することが求められます。

これらの対策を講じることで、企業はシャドーITによるセキュリティ上のリスクを軽減し、安全なAI活用を推進することができます。

私が企業様の監査をお手伝いする際、単に「未承認ツールを見つけて禁止する」ことだけを目的にしないよう助言しています。なぜなら、そのツールが使われている裏には、必ず「既存の環境では解決できない業務上の課題」が隠れているからです。そこを解決しない限り、いたちごっこは終わらないと私は考えています。

安全な利用方法の検討

企業が安全なAIの利用方法を検討する際には、いくつかの重要なポイントがあります。

まず、企業はAIの利用に関する明確なルールとガイドラインを作成し、従業員が遵守すべき事項を明確にすることが重要です。

例えば、機密情報や個人情報をAIツールに入力することを禁止したり、AIが生成したコンテンツの利用範囲を限定するなどのルールを設けることが考えられます。

また、企業は従業員に対して、AIの利用に関する研修を実施し、安全な利用方法や情報漏洩のリスクについて十分に解説することが重要です。

さらに、企業はAIツールのセキュリティ設定を適切に管理し、不正アクセスやデータ漏洩を防止するための対策を講じる必要があります。

これらの対策を講じることで、企業は安全なAI活用を推進し、リスクを最小限に抑えることができます。

ガイドライン策定において私が重要視しているのは、「禁止事項」だけでなく「具体的な活用事例(推奨事項)」もセットで提示することです。「あれもダメ、これもダメ」では従業員が萎縮してしまい、DXの芽を摘んでしまうことになりかねません。

データ入力と承認プロセスの確立

データ入力と承認プロセスを確立することは、シャドーAIによる情報漏洩のリスクを軽減するために非常に重要です。

まず、企業はAIに入力するデータの種類や範囲を明確にし、機密情報や個人情報などの重要なデータについては、AIへの入力を禁止するルールを設けることが考えられます。

次に、従業員がAIにデータを入力する際には、上長やセキュリティ担当者の承認を得ることを義務付ける承認プロセスを確立することが重要です。

この承認プロセスでは、データの入力目的やAIの利用方法が適切であるかを確認し、情報漏洩のリスクがないかを評価することが求められます。

また、企業はデータの入力履歴を記録し、定期的に監査することで、不適切なデータ入力やAIの利用を早期に発見することができます。

これらの対策を講じることで、企業はシャドーAIによる情報漏洩のリスクを大幅に軽減し、安全なAI活用を推進することができます。

ただ、実務の現場で「プロンプト入力のたびに上長の承認を得る」というのは、スピード感を損なうため現実的ではない場合も多いと私は感じています。そのため、包括的な利用許可を出した上で、ログ(履歴)を定期的にモニタリングするという事後チェック型の運用の方が、現場の負担も少なく定着しやすいでしょう。

企業がすべき対策

シャドーAI導入のメリットとデメリット

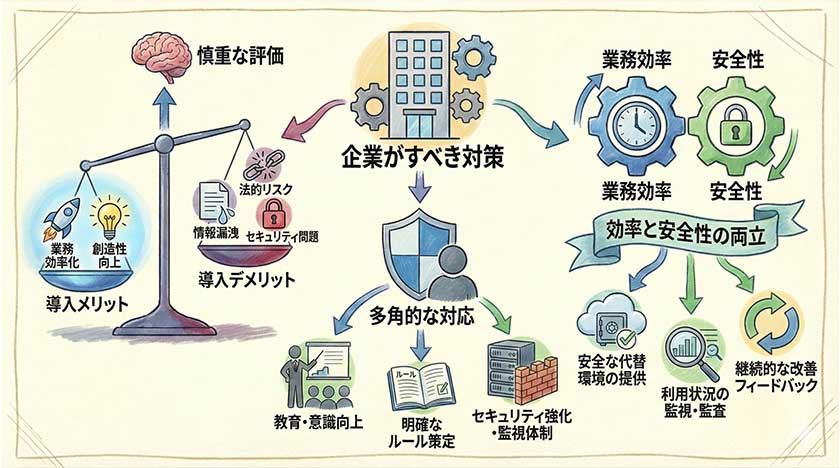

シャドーAIの導入には、業務の効率化や生産性の向上が期待できるというメリットがあります。

従業員が個人的にAIツールを導入することで、業務プロセスが迅速化され、より創造的な業務に集中できる可能性があります。

特に、ChatGPTのような生成AIは、文章作成やデータ分析などのタスクを効率的に行うことができ、業務の質を向上させることが期待できます。

しかし、その一方で、情報漏洩やセキュリティ上のリスク、法令遵守の問題などのデメリットも存在します。

企業が承認していないAIツールの利用は、データの管理が不十分になり、情報漏洩の危険性を高める可能性があります。

したがって、企業はシャドーAIの導入に際して、メリットとデメリットを慎重に評価し、適切な対策を講じる必要があります。

私はよくクライアントに「シャドーAIは、従業員の『もっと良くしたい』という叫び声だ」と伝えています。悪意があるわけではなく、既存のツールでは不十分だから使っているのです。この「現場の熱意」を潰さずにリスクだけを取り除く視点が、経営層には求められていると感じます。

深刻なリスクへの対応策

シャドーAIがもたらす深刻なリスクに対応するためには、企業は多角的な対策を講じる必要があります。

まず、企業は従業員に対して、シャドーAIのリスクや情報セキュリティに関する教育を徹底し、従業員の意識を向上させることが重要です。

次に、企業はAIの利用に関する明確なルールとガイドラインを作成し、従業員が遵守すべき事項を明確にする必要があります。

例えば、機密情報や個人情報をAIツールに入力することを禁止したり、AIが生成したコンテンツの利用範囲を限定するなどのルールを設けることが考えられます。

さらに、企業はセキュリティ対策を強化し、不正アクセスやデータ漏洩を防止するための対策を講じる必要があります。

これらの対策を講じることで、企業はシャドーAIによるリスクを軽減し、安全なAI活用を推進することができます。

技術的なブロック(アクセス制限など)ももちろん有効ですが、抜け穴はいくらでも作れてしまいます。結局のところ、私がこれまで見てきた中で最も効果が高かったのは、「なぜダメなのか」を腹落ちさせる教育、つまり「人のファイアウォール化」でした。

業務効率と安全性の両立

業務効率と安全性を両立させるためには、企業はAIの利用に関する包括的な戦略を策定する必要があります。

まず、企業は従業員が業務で利用できる安全なAIツールを選定し、それらのツールを従業員に提供することが重要です。

次に、企業はAIツールの利用状況を監視し、不適切な利用やセキュリティ上のリスクを早期に発見するための体制を構築する必要があります。

また、企業は従業員に対して、AIの利用に関する研修を定期的に実施し、安全な利用方法や情報漏洩のリスクについて十分に解説することが重要です。

さらに、企業はAIの利用に関するフィードバックを従業員から収集し、業務効率と安全性のバランスを最適化するための改善を継続的に行うことが求められます。

これらの対策を講じることで、企業は業務効率を向上させながら、情報漏洩のリスクを最小限に抑えることができます。

「禁止するなら代替案を出す」というのが鉄則です。安全な環境(例えばAzure OpenAI Serviceなどを活用した社内版ChatGPT)を用意し、「こっちの方が便利で安全だよ」と誘導することが、結果としてシャドーAIを撲滅する最短ルートだと私は確信しています。

シャドーAIとは?企業リスク、情報漏洩対策を解説&安全な活用法に関しての「よくある質問」

Q1: シャドーAIとは具体的にどのような状態を指すのですか?

シャドーAIとは、企業のシステム管理部門が把握・許可していないにもかかわらず、従業員が業務で生成AI(ChatGPTなど)を利用している状態を指します。 かつて問題となった「シャドーIT(許可外のデバイスやクラウド利用)」のAI版であり、利便性の高さゆえに現場で勝手に導入が進んでしまうのが特徴です。管理者の目が届かないところでAIが使われると、企業にとって深刻なセキュリティリスクとなります。

Q2: シャドーAIによって、どのような企業リスクが発生しますか?

主に「情報漏洩」と「権利侵害」の2つのリスクが挙げられます。 個人向けの無料版AIサービスなどは、入力したデータがAIの学習に再利用される設定になっていることが多く、機密情報や個人情報を入力すると、その内容が他者の回答として出力されてしまう恐れがあります。また、AIが生成した回答が他者の著作権を侵害していた場合、意図せず法律に抵触し、企業の社会的信用を失う可能性もあります。

Q3: 従業員がこっそりAIを使ってしまうのはなぜでしょうか?

主な理由は、「業務効率化への強いニーズ」と「会社側のルール整備の遅れ」のギャップにあります。 現場の従業員は「もっと早く仕事を終わらせたい」という善意でAIを利用しますが、会社が明確な利用規定(ガイドライン)を示していない場合、リスクを認識せずに手近なツールを使ってしまいます。また、会社がAI利用を一律に禁止していると、隠れてでも使いたいという心理が働き、かえってシャドーAIを加速させる原因となります。

Q4: シャドーAIを防ぐための「情報漏洩対策」には何が必要ですか?

まずは、「法人向けプラン」や「API連携」を利用した、データが学習に利用されない安全な環境を会社が提供することが最優先です。 その上で、CASB(キャスビー)などのセキュリティツールを導入し、未許可のAIサービスへのアクセスを可視化・制御する技術的な対策を講じます。しかし、技術だけでは限界があるため、「何を入力してはいけないか」を具体的に定めた利用ガイドラインの策定と、全従業員への教育をセットで行うことが不可欠です。

Q5: リスクを抑えつつ、安全に生成AIを活用するための第一歩は?

まずは「AIの利用を禁止するのではなく、管理下で解放する」という方針への転換が必要です。 具体的には、以下の3ステップから始めることを推奨します。

- 現状把握:アンケートやログ解析で、現場でどの程度AIが使われているか実態を調査する。

- 安全な環境の提供:入力データが保護されるエンタープライズ版(法人契約)のAIツールを導入する。

- 継続的なリテラシー教育:AIの特性やリスクを正しく理解し、「正しく怖がり、賢く使う」組織文化を醸成する。

DXやITの課題解決をサポートします! 以下の無料相談フォームから、疑問や課題をお聞かせください。40万点以上のITツールから、貴社にピッタリの解決策を見つけ出します。

このブログが少しでも御社の改善につながれば幸いです。

もしお役に立ちそうでしたら下のボタンをクリックしていただけると、 とても嬉しく今後の活力源となります。 今後とも応援よろしくお願いいたします!

IT・通信業ランキング | にほんブログ村 |

もしよろしければ、メルマガ登録していただければ幸いです。

【メルマガ登録特典】DX戦略で10年以上勝ち続ける実践バイブル『デジタル競争勝者の法則』をプレゼント!

今すぐプレゼントを受け取る

今すぐプレゼントを受け取る